설치

https://www.elastic.co/kr/downloads/logstash

Download Logstash Free | Get Started Now | Elastic

Download Logstash or the complete Elastic Stack (formerly ELK stack) for free and start collecting, searching, and analyzing your data with Elastic in minutes.

www.elastic.co

해당 페이지에서는 연결만 테스트하기 때문에, 변경할 부분이없다.

ㅁ 기본

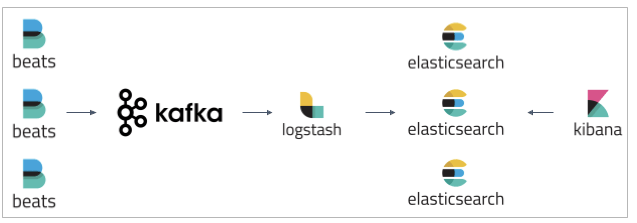

Input : Beats Port ( 5044 ) Output : Elastic Search ( 9200 )

ㅁ 실행방법

(설치폴더 bin)/logstash -f (설치폴더 conf)/logstash-sample.conf --config.reload.automatic

-f (path) 옵션 : config 파일위치 수동으로 지정

-config.reload.automatic 옵션 : 컨피그파일이 수정될때마다 자동으로 반영

Filebeat → 연결테스트

1. Output 을 CMD 창에 나타내도록 변경한다.

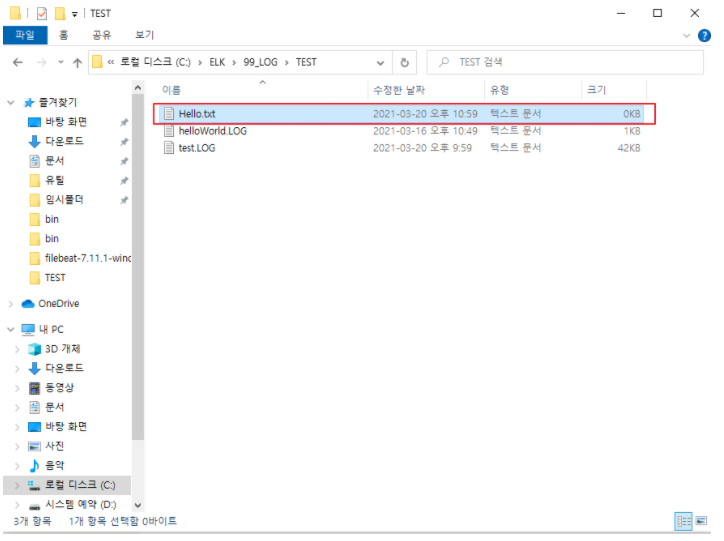

2. *.txt 파일에 데이터 입력시, Logstash로 전달되는지 확인

'모니터링 > ELK' 카테고리의 다른 글

| (1) ELK 풀 스택 구현해보기 - Filebeat (0) | 2021.06.27 |

|---|---|

| (0) ELK란? (0) | 2021.06.27 |